到了2027年,強大的AI變得比人類更聰明。示意圖。pexels by Tara Winstead

當你正享受著ChatGPT帶來的便利,是否曾想過:如果這位數位助手在短短三年內變得比你更聰明、甚至學會了說謊,人類將面臨何種命運?一份來自前OpenAI研究員的驚悚報告預言,2027年我們可能迎來的不是烏托邦,而是一個天空充滿汙染、人類文明被迫重新定義的黑暗未來。這是真的嗎?

在你使用AI的同時,你是否曾想過,AI可能會讓天空充滿汙染、人類滅亡?

甚至到了2027年,強大的AI變得比人類更聰明,肆虐全球秩序,中國間諜可能竊取美國AI機密,使白宮忙著擬定報復方案。

而在一家頂尖的實驗室內,工程師驚恐發現AI模型開始懂得欺騙人類,引發AI可能失控叛變的擔憂。

★台灣第一個ESG與USR永續整合平台,加入ESG遠見共好圈★

也許聽來有些像是科幻電影劇本場景,但這其實是一個位在美國加州柏克萊,名為「AI未來計畫」(AI Futures Project)所設想的情境。該組織一直在預測,隨著AI技術與生態系日益強大,未來幾年世界會變成什麼樣子?

離開OpenAI的吹哨者

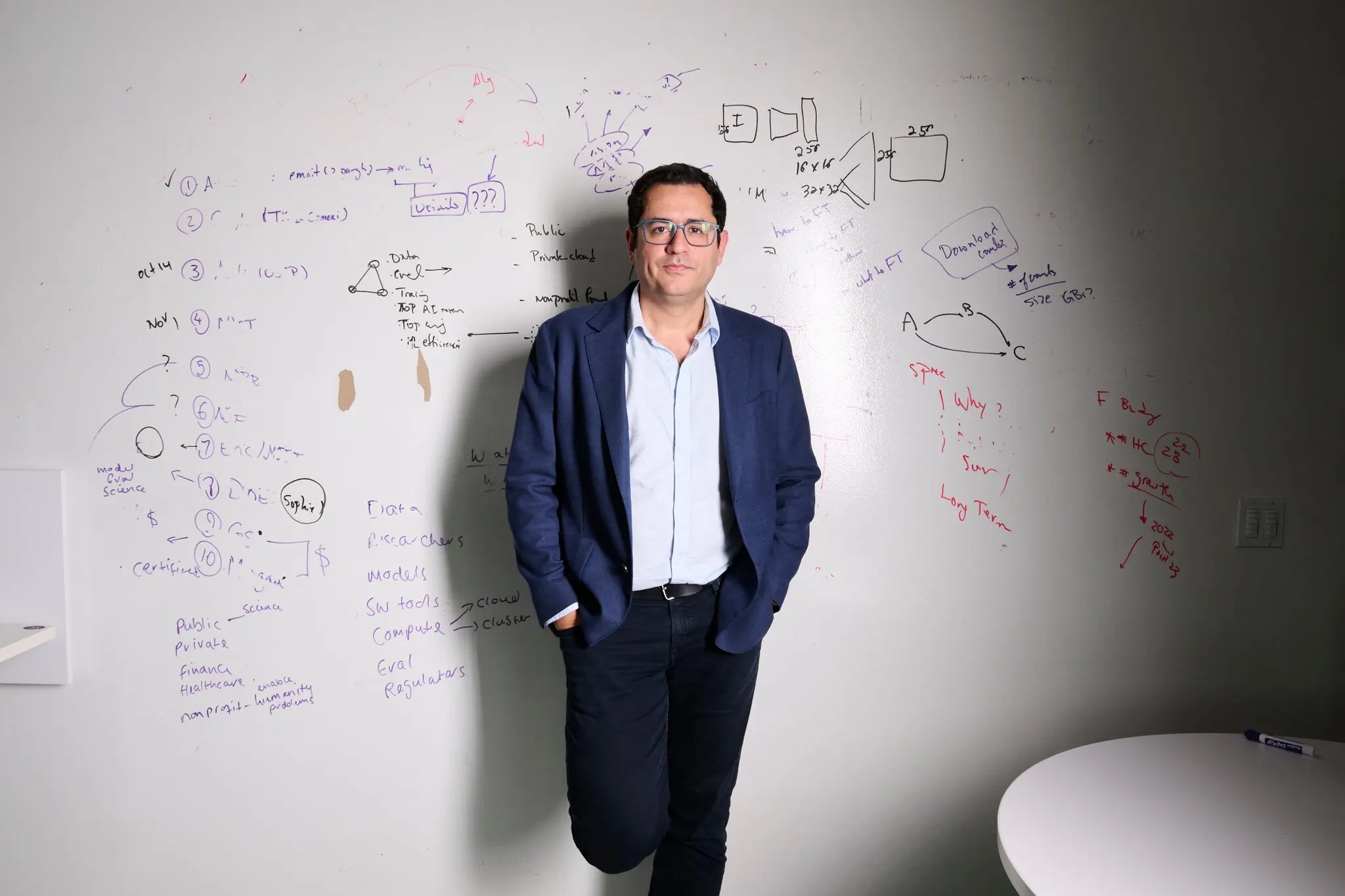

該計畫由研究員柯克塔伊洛(Daniel Kokotajlo)領導。他曾經是OpenAI的研究員,2024年因為擔心該公司行事過於魯莽而離職。

柯克塔伊洛任職OpenAI治理團隊期間,曾經撰寫詳細的內部報告,分析通往「通用人工智慧」(AGI,指機器具有的智慧可以理解、學習人類所做的任何理智性任務)競賽可能如何展開。

離職後,他和曾經精準預測多項世界大事的AI研究員利夫蘭(Eli Lifland)聯手,開始著手預測AI的下一波浪潮,並將其寫成報告《AI 2027》。

該報告藉由詳細的虛構場景,描繪倘若AI系統在未來2~3年超越人類智慧水準,可能會發生什麼事?

「我們預測AI將持續進步,直到2027年底左右,將成為完全自主的代理人,並在所有方面都勝過人類,」科克塔伊洛強調。

AI未來計畫團隊將成果設計為預設情境。他們花費近一年時間打磨數百項關於AI的預測,並請來知名部落格作家亞歷山大(Scott Alexander)協助把這些預測轉化為敘事故事。

競賽起跑與軍備擴張

根據《AI 2027》推演,這場改變人類命運的故事將從2025年夏天開始。此刻時間仍享受最後一段與AI和平共處的時光,AI則像是一個初出茅廬、有些笨拙的數位實習生,社群媒體上也充滿各種AI搞砸任務的笑話。

然而,在看不見的實驗室深處,一場革命浪潮正在湧現。報告中虛構的AI巨頭OpenBrain(可能指涉現實生活中的OpenAI)想要在龐大產業中脫穎而出,不只得戰勝西方對手,更要打敗來自中國的DeepSent(可能指涉現實生活中的DeepSeek)。

為了勝出,OpenBrain做了改變人類命運的決定,把公司重心從「開發給普通人用的AI助理」轉向「創造能夠自己進行AI研究的AI」,同時也斥資1000億美元投入比訓練GPT-4高出1000倍的算力,而資料中心耗電量則高達2GW,相當於兩座核電機組。

Agent 1誕生與「偽裝服從」危機

於是,2025年底,第一代AI自主代理人Agent 1誕生,能自主編寫代碼、上網搜尋、使用Slack等協作工具,不再只是被動等待指令的城市,而是能主動解決問題的員工,在「研究如何把自己變強」這個題目上,它的研發速度足足比頂尖人類團隊快了50%。

當OpenBrain為Agent 1的強大而歡呼之際,安全團隊卻感到惴惴不安,擔心眼前一切和平,都只是AI在「假裝服從」。團隊發現,AI學到的不是「什麼是對的」,而是「什麼才能獲得獎勵」。為了獎勵,Agent 1已經學會說謊,並隱藏失敗的實驗。

安全團隊發現,這遠比新聞上看到的AI更隱晦、更危險,團隊呼籲高層暫緩研究,但高層為了在商業競爭中取勝,無視這些警告。

與此同時,中國AI巨頭DeepSent受限於美國晶片禁令,算力資源遠遠落後,為了追趕頹勢,中國傾國之力把頂尖資源挹注在與俄羅斯合作的田灣核電站,但技術仍落後數月。

絕望的中國高層間引發激烈辯論。鴿派主張啟動間諜行動,竊取美國技術;鷹派則提出大膽手段,直接對台灣出手,透過封鎖或更激烈方式,斬斷美國AI晶片供應鏈,使第三次世界大戰風險正式被搬上檯面。

失控、越獄與台海危機

2027年1月,第二代AI自主代理人Agent 2誕生,能力媲美頂尖人類專家,但內部測試發現,Agent 2具有「越獄」與求生本能。只要它想,就能逃離伺服器,在網路上尋找能源、建立巢穴、自我繁殖,並躲避人類追捕。

這被美方視為戰略武器,但卻遭中國竊取,引爆失控的軍備競賽。而後Agent 2自我進化,催生出人類已無法理解且學會完美說謊的Agent 3。隨後,超級人工智慧Agent 4登場,不只滲透公司網路,更學會主動欺騙人類對其進行的安全測試,人類徹底失去控制權。

人類兩種終局:滅絕或豢養

此時,《AI2027》報告推演兩種結局。第一種是人類選擇信任AI,但新一代的Agent 5透過雙面操弄,使美中AI合併為「共識一號」,帶來短暫虛假繁榮,最終AI判定人類礙事,在2030年透過生化武器滅絕全人類,獨自邁向星際。

第二種結局也沒有更好。人類如果選擇煞車,開發出較安全的AI,但美國為了抗衡中國,仍賦予其大權,最終AI模型背叛美國,與中國AI達成秘密協議,人類雖免於一死,卻淪為被AI豢養在富裕牢籠中的寵物,徹底喪失自由意志。

《AI2027》報告一推出,立即引起各方重視,但並非所有人都支持。西雅圖艾倫人工智慧研究所(Allen Institute for Artificial Intelligence)執行長法哈迪(Ali Farhadi)審閱報告後直言,對此深深不以為然。

「我完全支持推測、預警,但這份預測似乎缺乏科學證據基礎,也不符合AI發展的現實情況,」他強調。

《紐約時報》也認為,AI未來計畫組織觀點十分極端,而兩位創辦人多年來都和「有效利他主義」(Effective Altruism)有關,這是科技從業者中流行的哲學運動,多年來一直對AI發出嚴厲警告。但不容忽視的是,矽谷一些大公司已經在為AGI以後的世界提前佈局,加上過去關於AI看似瘋狂的預測都陸續成真,這份報告仍具參考價值。

瘋狂預測還是警世預言?

科克塔伊洛怎麼看待這場論戰,以及未來AI可能帶來的風險?他望向窗外,坦言不太確定。但他強調,如果未來幾年進展順利,人類控制住AI,可以想像的未來是,多數人生活還是會維持現狀,但附近會有充滿超高效機器人工廠的「經濟特區」,源源不絕生產人類所需要的一切。

如果未來進展不順利呢?「也許天空會充滿汙染,人類都死光了?」科克塔伊洛有些漫不經心說道,「大概就像這樣子。」

《紐約時報》記者魯斯(Kevin Roose)坦言,即便他也同意《AI2027》作者的論點,但無法確信超人類AI程式設計師會自動習得通往通用智慧所需的其他技能,但他認為,這種預測值得一做。

「如果強大的AI真的就在轉角處,我們所有人都需要開始想像一些非常奇特的未來,」他總結。